Quanto dovrebbero pagare i governi per prevenire le catastrofi e il ruolo limitato del lungoterminismo

Sarebbe molto grave se l’umanità fosse vittima di una guerra nucleare, una pandemia mortale o un disastro causati dall’IA. Questo per due motivi principali. Il primo è che queste catastrofi potrebbero uccidere miliardi di persone. Il secondo è che potrebbero causare l’estinzione dell’umanità o il collasso permanente della civiltà.

I lungoterministi sostengono che l’umanità dovrebbe aumentare gli sforzi per evitare guerre nucleari, pandemie e disastri causati dall’IA.1 Uno dei principali argomenti dei lungoterministi a favore di questa conclusione si appella al secondo motivo: queste catastrofi potrebbero portare all’estinzione dell’umanità o al collasso permanente della civiltà, e quindi impedire a un numero enorme di persone potenziali di vivere una vita felice in un futuro piacevole. Questi eventi si qualificherebbero quindi come : catastrofi che distruggono il potenziale a lungo termine dell’umanità.

Sebbene questo ragionamento lungoterminista sia stato convincente per molti, presenta almeno due limiti: limiti che sono particolarmente gravi se la conclusione che si intende trarre è che i governi democratici dovrebbero aumentare i loro sforzi per prevenire le catastrofi. In primo luogo, l’argomentazione si basa su una premessa che molti rifiutano: che sarebbe una enorme perdita morale se le persone future non esistessero mai. In secondo luogo, è esagerata. Date altre affermazioni plausibili, costruire una politica su questa premessa non solo porterebbe i governi ad aumentare gli sforzi per prevenire le catastrofi, ma anche a imporre costi estremi alla generazione presente in cambio di minuscole riduzioni del rischio di catastrofe esistenziale. Poiché la preoccupazione della maggior parte delle persone per l’esistenza delle generazioni future è limitata, questa politica sarebbe inaccettabile da un punto di vista democratico. Ne consegue che i governi non possono usare l’argomentazione lungoterminista per guidare la loro politica di prevenzione delle catastrofi.

In questo capitolo proponiamo un’analisi costi-benefici standard per ridurre il rischio di catastrofi. Mostriamo che, date stime plausibili del rischio catastrofico e dei costi per ridurlo, molti interventi a disposizione dei governi superano l’analisi costi-benefici. Pertanto, la necessità di evitare le catastrofi non dipende dal lungoterminismo. In realtà, sosteniamo che i governi dovrebbero fare molto di più per ridurre il rischio catastrofico anche se le generazioni future non contassero affatto. La prima ragione per cui una catastrofe sarebbe negativa, cioè che potrebbero morire miliardi di persone, giustifica di per sé un’azione molto più incisiva rispetto allo status quo. Questa argomentazione basata sugli interessi delle persone attuali evita entrambi i limiti dell’argomentazione lungoterminista: presuppone solo che la generazione presente sia importante e non si spinge troppo oltre. Tuttavia, come l’argomentazione lungoterminista, implica che i governi dovrebbero fare molto di più per ridurre il rischio catastrofico.

Sosteniamo quindi che l’obiettivo dei lungoterministi nella sfera politica dovrebbe essere quello di far adottare ai governi una politica sulle catastrofi basata sull’analisi costi-benefici. Questo obiettivo è raggiungibile, perché l’analisi costi-benefici (ACB) è già uno strumento standard per il processo decisionale dei governi e perché il passaggio a una politica sulle catastrofi basata sull’ACB andrebbe a beneficio della generazione presente. L’adozione di una politica basata sull’ACB ridurrebbe inoltre il rischio di catastrofe esistenziale in misura quasi uguale all’adozione di una politica lungoterminista forte fondata sulla premessa che sarebbe una enorme perdita morale se le generazioni future non esistessero mai.

Proponiamo quindi che la visione lungoterminista possa svolgere un ruolo supplementare nella politica governativa contro le catastrofi. I lungoterministi possono sostenere la loro visione, aumentando così la disponibilità delle persone attuali a pagare per i beni lungoterministi puri: beni che non danno molti benefici alla generazione presente, ma che migliorano le prospettive sul lungo periodo dell’umanità. Questi beni lungoterministi puri includono in particolare i rifugi progettati per aiutare la civiltà a riprendersi da catastrofi future. Quando le persone attuali sono disposte a pagare per questi beni, i governi dovrebbero finanziarli. Questa spesa avrebbe costi modesti per chi vive oggi e grandi benefici attesi per il futuro a lungo termine.

Concludiamo sostenendo che i lungoterministi dovrebbero impegnarsi ad agire nella sfera politica secondo una politica sulle catastrofi basata sull’ACB. Questo impegno aiuterebbe a raggiungere un risultato molto migliore dello status quo, sia per la generazione presente che per il futuro a lungo termine.

Come già detto, utilizzeremo l’analisi costi-benefici standard per sostenere la necessità di aumentare la spesa pubblica per la prevenzione delle catastrofi.b Ci concentriamo sul governo degli Stati Uniti, ma i nostri punti si applicano anche ad altri Paesi (con modifiche che saranno chiare in seguito). Ci concentriamo anche sul rischio di catastrofi globali, che definiamo come eventi che uccidono almeno 5 miliardi di persone. Molti eventi potrebbero costituire una catastrofe globale nei prossimi anni, ma ci concentriamo su tre in particolare: guerre nucleari, pandemie e disastri causati dall’IA. Ridurre il rischio di queste catastrofi ha un rapporto costo-efficacia particolarmente elevato.

La prima cosa da stabilire è che il rischio è significativo, compito che comporta già una difficoltà. Non c’è ancora stata una catastrofe globale secondo la nostra definizione, quindi non possiamo basare le nostre stime del rischio sulla frequenza sul lungo periodo. Ma questa difficoltà è superabile perché possiamo usare altre considerazioni per guidare le nostre stime. Si tratta di quasi-incidenti (come la crisi dei missili di Cuba), di modelli statistici (come le estrapolazioni della legge di potenza) e di tendenze empiriche (come i progressi dell’intelligenza artificiale). Non disponendo dello spazio necessario per valutare in dettaglio tutte le considerazioni pertinenti, ci basiamo principalmente sulle stime dei rischi pubblicate in precedenza. In attesa di ulteriori indagini, queste stime dovrebbero essere il nostro punto di partenza. Si noti anche che non è necessario che queste stime siano perfettamente accurate perché le nostre conclusioni siano valide. Spesso è sufficiente che i rischi superino un valore basso.

Cominciamo con il rischio di guerra nucleare. Toby Ord stima che il rischio esistenziale di una guerra nucleare nei prossimi 100 anni sia di circa 1 su 1000.4 Si noti, tuttavia, che il “rischio esistenziale” si riferisce al rischio di una catastrofe esistenziale: una catastrofe che distrugge il potenziale a lungo termine dell’umanità. Uno standard molto alto, dal momento che qualsiasi catastrofe da cui l’umanità si riprende (anche se la ripresa dovesse richiedere molti millenni) non conta come catastrofe esistenziale. Le guerre nucleari possono essere enormemente distruttive senza per questo rappresentare una catastrofe esistenziale, quindi la stima di Ord del rischio di una guerra nucleare “su larga scala” è molto più alta, circa il 5 % nei prossimi 100 anni.5 Questa cifra è all’incirca allineata con le nostre opinioni (circa il 3 %) e con altre stime pubblicate del rischio esistenziale. Al momento in cui scriviamo, la comunità di previsione Metaculus stima il rischio di guerra termonucleare prima del 2070 all’11 %.6 c L’aggregazione di stime di esperti e super-previsori di Luisa Rodriguez indica il rischio di guerra nucleare tra Stati Uniti e Russia allo 0,38 %,7 mentre Martin E. Hellman stima che il rischio annuale di guerra nucleare tra Stati Uniti e Russia derivante da uno scenario simile alla crisi dei missili di Cuba è dello 0,02-0,5 %.8

Riconosciamo che ognuna di queste stime comporta difficili valutazioni. Tuttavia, riteniamo che sarebbe avventato supporre che il rischio reale di guerra nucleare in questo secolo sia inferiore all’1 %. Ecco alcune ragioni per essere cauti. Le armi nucleari sono state una minaccia per un tempo corrispondente a una sola vita umana, e in questi anni abbiamo già accumulato un numero impressionante di incidenti evitati per un soffio. La crisi dei missili di Cuba è l’esempio più famoso, ma abbiamo anche resoconti declassificati di molti incidenti e falsi allarmi.9 E anche se un conflitto nucleare sarebbe probabilmente devastante per tutte le parti coinvolte, i leader hanno spesso incentivi egoistici per la “politica del rischio calcolato” e possono comportarsi in modo irrazionale sotto pressione. In prospettiva, i futuri sviluppi tecnologici potrebbero sconvolgere il delicato equilibrio della deterrenza. E non possiamo presumere che una guerra nucleare danneggerebbe solo i suoi bersagli diretti. Le ricerche hanno suggerito che il fumo delle città in fiamme impiegherebbe anni per dissiparsi, durante i quali le temperature globali e le precipitazioni si abbasserebbero abbastanza da uccidere la maggior parte dei raccolti.d Questo porta Rodriguez a stimare che un conflitto nucleare tra Stati Uniti e Russia causerebbe una carestia che ucciderebbe 5,5 miliardi di persone in aspettativa.10 Uno di noi (Shulman) stima un rischio minore di questo tipo di inverno nucleare, un numero medio inferiore di testate dispiegate in uno scambio nucleare tra Stati Uniti e Russia e una maggiore probabilità che le misure di emergenza riescano a ridurne gli effetti, ma comunque le vittime previste sono miliardi.

Le pandemie causate da agenti patogeni ingegnerizzati in laboratorio sono un’altra grande preoccupazione. Ord stima che il rischio esistenziale nel prossimo secolo derivante da queste pandemie ingegnerizzate si aggiri intorno al 3 %.11 E come nel caso della guerra nucleare, le pandemie ingegnerizzate potrebbero essere estremamente distruttive senza costituire una catastrofe esistenziale, quindi la stima di Ord del rischio catastrofe globale derivante dalle pandemie ingegnerizzate andrebbe corretta al rialzo rispetto a questa cifra del 3 %. Al momento in cui scriviamo, Metaculus suggerisce che c’è una probabilità del 9,6 % che un agente patogeno ingegnerizzato faccia diminuire la popolazione umana di almeno il 10 % in un periodo di 5 anni o meno entro il 2100.e In un sondaggio del 2008 tra i partecipanti a una conferenza sulle catastrofi globali, la mediana degli intervistati ha stimato una probabilità del 10 % che una pandemia ingegnerizzata uccida almeno 1 miliardo di persone, e una probabilità del 2 % che una pandemia ingegnerizzata causi l’estinzione umana prima del 2100.12

Queste stime si basano su una moltitudine di fattori, di cui riportiamo una piccola selezione. Le malattie possono essere molto contagiose e molto letali.f Non c’è motivo di supporre che le malattie ingegnerizzate non possano essere entrambe le cose. Gli scienziati continuano a condurre ricerche in cui gli agenti patogeni vengono modificati per aumentarne la trasmissibilità, la letalità e la resistenza ai trattamenti.13 Abbiamo anche numerose segnalazioni di fughe di laboratorio: casi in cui gli agenti patogeni sono stati rilasciati accidentalmente dalle strutture di ricerca biologica e hanno potuto infettare la popolazione umana.14 Molti Paesi hanno avviato programmi per l’uso di armi biologiche nel corso del XX secolo e le armi biologiche sono state utilizzate in entrambe le guerre mondiali.15 Gruppi terroristici come il culto Aum Shinrikyo hanno tentato di utilizzare agenti biologici per causare stragi.16 I loro sforzi sono stati ostacolati dalla mancanza di tecnologia e di competenze, ma da allora la capacità collettiva dell’umanità per il bioterrorismo è cresciuta notevolmente. Un numero significativo di persone ha oggi la capacità di provocare una catastrofe biologica e questo numero sembra destinato ad aumentare ulteriormente nei prossimi anni.17

Ord stima il rischio esistenziale legato all’intelligenza artificiale generale (IAG) al 10 % nel prossimo secolo.18 Questa cifra è il prodotto di una probabilità del 50 % di IAG di livello umano entro il 2120 e di un rischio del 20 % di catastrofe esistenziale, condizionata alla probabilità di IAG entro il 2120.19 Nel frattempo, Joseph Carlsmith stima una probabilità del 65 % che entro il 2070 sarà possibile e finanziariamente fattibile costruire sistemi artificiali di livello umano in grado di pianificare, strategizzare e superare gli esseri umani in domini importanti.20 Il rischio (incondizionato) legato all’IA è superiore al 10 % prima del 2070.21 La previsione aggregata di un recente sondaggio tra i ricercatori sul machine learning è di una probabilità del 50 % di intelligenza artificiale di alto livello entro il 2059.22 L’intervistato mediano di questo sondaggio ha stimato una probabilità del 5 % che l’IA causi l’estinzione umana o privi del potere l’umanità in modo permanente.23 Le nostre stime sono più vicine a Carlsmith e agli intervistati del sondaggio per quanto riguarda le tempistiche e più vicine a Ord per quanto riguarda il rischio esistenziale.

Queste stime sono le più speculative: le armi nucleari e gli agenti patogeni ingegnerizzati sono già presenti nel mondo, mentre l’IAG a livello umano deve ancora arrivare. In questo capitolo non possiamo fare un’analisi completa del rischio legato all’IA, ma ne forniamo una bozza. Le capacità dell’IA stanno crescendo rapidamente, in parte grazie ai rapidi miglioramenti degli algoritmi e soprattutto all’aumento della potenza di calcolo. Prima del 2010, la potenza di calcolo impiegata per l’addestramento dei modelli di IA è cresciuta in linea con la legge di Moore, ma nel recente boom di deep learning è aumentata molto più rapidamente, con un tempo medio di raddoppio di 6 mesi in quel periodo.24 Modelli più grandi e addestramenti più lunghi hanno portato a notevoli progressi in ambiti come la visione artificiale, il linguaggio, la modellazione delle proteine e i giochi. Nei prossimi 20 anni è probabile che i primi sistemi di IA si avvicinino alla scala di calcolo del cervello umano, grazie al miglioramento dell’hardware e all’aumento della spesa per l’addestramento, che passerà dagli attuali milioni di dollari a molti miliardi di dollari.25 L’estrapolazione delle tendenze passate suggerisce che questi sistemi di IA potrebbero avere capacità pari a quelle del cervello umano in un’ampia gamma di settori.

Gli sviluppatori di IA addestrano i loro sistemi utilizzando una funzione di ricompensa (o funzione di perdita) che assegna valori agli output del sistema, insieme a un algoritmo che modifica il sistema per ottenere prestazioni migliori in base alla funzione di ricompensa. Ma codificare le intenzioni umane in una funzione di ricompensa si è rivelato estremamente difficile, come dimostrano i molti casi registrati di sistemi di intelligenza artificiale che hanno ottenuto un’elevata ricompensa comportandosi in modi non previsti dai loro progettisti.26 Questi includono sistemi che mettono in pausa Tetris per sempre per evitare di perdere,27 che usano trucchi con la fotocamera per ingannare i valutatori umani e far loro credere che una mano robotica stia completando un compito28 e che si comportano in modo diverso sotto osservazione per evitare penalità per la riproduzione.29 Abbiamo anche documentato casi di IA che adottano obiettivi che producono un’alta ricompensa nell’addestramento, ma che differiscono in modo significativo dagli obiettivi previsti dai loro progettisti.30 Un esempio è rappresentato da un modello addestrato a vincere un videogioco raggiungendo una moneta a destra del livello. Il modello ha mantenuto la sua capacità di navigare nell’ambiente quando la moneta è stata spostata, ma è diventato chiaro che il suo vero obiettivo era andare il più a destra possibile, piuttosto che raggiungere la moneta.31 Finora, questi problemi di manipolazione della ricompensa e di errata generalizzazione degli obiettivi sono stati di scarsa importanza, perché siamo stati in grado di bloccare i sistemi che si comportavano male o di alterare le loro funzioni di ricompensa. Ma la situazione è destinata a cambiare quando i sistemi di IAG impareranno a capire e ad agire nel mondo: una potente IAG potrebbe imparare che lasciarsi spegnere o modificare è un modo poco efficace di raggiungere il suo obiettivo. E data un’ampia varietà di obiettivi, questo tipo di IAG avrebbe motivo di ottenere buoni risultati nell’addestramento e di nascondere il suo vero obiettivo fino a quando i sistemi IAG non saranno collettivamente abbastanza potenti da prendere il controllo dei loro processi di ricompensa (o perseguire in altro modo i loro obiettivi) e sconfiggere qualsiasi risposta umana.

Questo è un modo in cui un’IAG disallineata potrebbe essere disastrosa per l’umanità. Per evitare questo esito è probabile che sia necessario lavorare ancora molto sull’allineamento dell’IA con le intenzioni umane, oltre che sull’impiego cauto di IA avanzate per consentire un’adeguata progettazione e verifica della sicurezza. Purtroppo, gli incentivi economici e geopolitici possono portare a una cura molto minore di quella necessaria. Le aziende e le nazioni in competizione tra loro possono prendere scorciatoie ed esporre l’umanità a gravi rischi nella corsa alla costruzione dell’IAG.32 Il rischio è esacerbato dalla dinamica della “maledizione del vincitore”: a parità di condizioni, sono gli attori che più sottovalutano i pericoli dell’implementazione ad avere maggiori probabilità di farlo.33

Assumendone l’indipendenza e combinando le stime di Ord sul rischio legato all’IA del 10 %, sulle pandemie ingegnerizzate del 3 % e sulla guerra nucleare del 5 %, si ottiene un rischio di catastrofe globale da queste fonti pari ad almeno il 17 % nei prossimi 100 anni.g Se assumiamo che il rischio per decennio sia costante, il rischio nel prossimo decennio è di circa l’1,85 %.h Se assumiamo anche che il rischio di ogni persona di morire in questo tipo di catastrofe è uguale, allora (a condizione che non muoia in altri modi) il rischio di ogni cittadino statunitense di morire in questo tipo di catastrofe nel prossimo decennio è di almeno 5/9 × 1,85 % ≈ 1,03 % (poiché, secondo la nostra definizione, una catastrofe globale ucciderebbe almeno 5 miliardi di persone, e si prevede che la popolazione mondiale rimarrà sotto i 9 miliardi fino al 2033). Secondo le proiezioni della piramide demografica statunitense, il 6,88 % dei cittadini statunitensi oggi in vita morirà in altri modi nel corso del prossimo decennio.i Ciò suggerisce che i cittadini statunitensi oggi in vita hanno in media circa l’1 % di probabilità di essere uccisi in una guerra nucleare, in una pandemia ingegnerizzata o in un disastro legato all’IA nel prossimo decennio. Si tratta di un rischio circa dieci volte superiore a quello di rimanere uccisi in un incidente stradalej.

Ci sono buone ragioni per pensare che il rischio catastrofico globale nei prossimi anni sia significativo. Sulla base delle stime dell’Ord, suggeriamo che il rischio per i cittadini statunitensi di morire in una guerra nucleare, in una pandemia o in un disastro causato dall’IA nel prossimo decennio è in media di circa l’1 %. Ora analizziamo alcuni modi per ridurre questo rischio.

Il bilancio 2023 del governo Biden elenca molti modi per ridurre il rischio di catastrofi biologiche.34 Tra questi, lo sviluppo di dispositivi di protezione individuale avanzati e di prototipi di vaccini per le famiglie di virus che hanno maggiori probabilità di causare pandemie.k Il governo degli Stati Uniti può anche migliorare la biosicurezza dei laboratori, migliorando le procedure di formazione, la valutazione dei rischi e le attrezzature.35 Un’altra priorità è il miglioramento delle nostre capacità in materia di scienza forense microbica (compresa la capacità di rilevare agenti patogeni ingegnerizzati), in modo da poter identificare e scoraggiare meglio i potenziali individui malintenzionati.36 In relazione a ciò, il governo degli Stati Uniti può rafforzare la Convenzione per le armi biologiche aumentando il budget e il personale dell’organismo responsabile della sua attuazione e lavorando per concedere loro il potere di indagare su sospette violazioni.37 La Nuclear Threat Initiative raccomanda di istituire un’autorità globale che si occupi, tra l’altro, di prevenire le catastrofi causate dalle biotecnologie.38 Un’altra priorità fondamentale è lo sviluppo di tecnologie efficaci contro qualsiasi agente patogeno. Una di queste tecnologie è il Nucleic Acid Observatory, che monitorerebbe i corsi d’acqua e le acque reflue alla ricerca di frequenze variabili di agenti biologici, consentendo l’individuazione precoce di potenziali minacce biologiche39.

Il governo degli Stati Uniti può anche ridurre il rischio di guerra nucleare in questo decennio. Ord raccomanda di riavviare il Trattato sulle forze nucleari a medio raggio, di togliere i missili balistici intercontinentali statunitensi dall’allerta istantanea (“Launch on Warning”) e di aumentare la capacità dell’Agenzia internazionale per l’energia atomica di verificare che le nazioni rispettino gli accordi di salvaguardia.40 Altre raccomandazioni provengono dal rapporto Future Proof del Centre for Long-Term Resilience.41 Sono rivolte al governo del Regno Unito ma si applicano anche agli Stati Uniti. Le raccomandazioni includono l’impegno a non incorporare i sistemi di intelligenza artificiale nei sistemi di comando, controllo e comunicazioni nucleari (NC3) e a fare pressione per stabilire questa norma a livello internazionale.l Un’altra è l’impegno a evitare operazioni informatiche che abbiano come obiettivo l’NC3 dei firmatari del Trattato di non proliferazione nucleare e a stabilire un accordo multilaterale in tal senso. La Nuclear Threat Initiative offre al governo Biden molte raccomandazioni per ridurre il rischio nucleare, alcune delle quali sono già state accolte.42 Altre includono l’impegno per far entrare in vigore il Trattato sulla messa al bando totale degli esperimenti nucleari, il ripristino dei limiti del Piano d’azione congiunto globale sull’attività nucleare dell’Iran e l’aumento degli sforzi diplomatici degli Stati Uniti con Russia e Cina.43 m

Per ridurre i rischi legati all’IA, il governo statunitense può finanziare la ricerca sulla sicurezza dell’IA. Ciò dovrebbe includere la ricerca sull’allineamento legata all’IA per ridurre il rischio di una presa del potere catastrofica da parte dell’IA, assicurandosi che anche i sistemi di IA molto potenti facciano ciò che intendiamo, nonché la ricerca sull’interpretabilità dell’IA per aiutarci a comprendere il comportamento delle reti neurali e a supervisionare meglio il loro addestramento.44 Il governo degli Stati Uniti può anche finanziare la ricerca e il lavoro sulla governance dell’IA, concentrandosi sull’elaborazione di norme, politiche e istituzioni per garantire che lo sviluppo dell’IA sia vantaggioso per l’umanità.45

Secondo le nostre proiezioni, il finanziamento di questa serie di interventi per il prossimo decennio costerebbe meno di 400 miliardi di dollari.n Ci aspettiamo inoltre che questa serie di interventi riduca il rischio catastrofico globale nel prossimo decennio di almeno 0,1pp (punti percentuali). Una difesa completa di questa affermazione richiederebbe più dettagli di quelli che possiamo inserire in questo capitolo, ma ecco un modo per illustrare la plausibilità dell’affermazione. Immaginiamo un enorme insieme di mondi come il nostro mondo nel 2023. Ogni mondo di questo insieme è diverso rispetto alle caratteristiche del nostro mondo su cui siamo incerti, e i mondi con una certa caratteristica si presentano nell’insieme in proporzione alle nostre migliori prove sulla presenza di quella caratteristica nel nostro mondo. Se, per esempio, la migliore valutazione delle prove disponibili suggerisce che c’è una probabilità del 55 % che il prossimo presidente degli Stati Uniti sia un Democratico, allora il 55 % dei mondi del nostro insieme ha un Democratico come prossimo presidente. Sosteniamo che in almeno 1 su 1 000 di questi mondi gli interventi che raccomandiamo sopra eviterebbero una catastrofe globale in questo decennio. Si tratta di una soglia bassa e ci sembra plausibile che gli interventi di cui sopra la soddisfino. La domanda che ci poniamo ora è: dato questo profilo di costi e benefici, questi interventi superano un test standard di analisi costi-benefici?

Per valutare gli interventi che pensiamo possano salvare vite umane, l’analisi costi-benefici inizia con la valutazione della riduzione del rischio di mortalità, in cui si attribuisce un valore monetario alla riduzione del rischio di morte dei cittadini.46 Per farlo, si determina innanzitutto quanto un campione rappresentativo di cittadini è disposto a pagare per ridurre di un determinato incremento (spesso circa 0,01pp, o 1 su 10 000) il proprio rischio di morire quest’anno. Un metodo possibile consiste nel chiedere ai cittadini di esprimere le loro preferenze. Un altro metodo consiste nell’osservare il comportamento delle persone, in particolare le loro scelte su cosa acquistare e quali lavori intraprendere, ottenendo così le loro preferenze rivelate.o

Le agenzie governative statunitensi utilizzano metodi come questi per stimare quanto i cittadini americani sono disposti a pagare per ridurre il loro rischio di morte.p Questa cifra viene poi utilizzata per calcolare il valore di una vita statistica (VVS): il valore atteso di una vita salvata attraverso piccole riduzioni del rischio di mortalità per molte persone. La cifra principale del VVS utilizzata dal Dipartimento dei Trasporti degli Stati Uniti per il 2021 è di 11,8 milioni di dollari, con un intervallo che tiene conto di vari tipi di incertezza e che va da circa 7 milioni di dollari a 16,5 milioni di dollari.47 q Queste cifre vengono utilizzate nelle analisi costi-benefici delle politiche che ci si aspetta salveranno vite umane. I costi e i benefici che si verificheranno in futuro sono scontati a un tasso annuale costante. L’Environmental Protection Agency (EPA) utilizza tassi di sconto annuali del 2 % e del 3%; l’Office of Information and Regulatory Affairs (OIRA) indica alle agenzie di condurre le analisi utilizzando tassi di sconto annuali del 3 % e del 7 %.48 La logica è quella dei costi di opportunità e del tasso di preferenza temporale pura delle persone.49

Passiamo ora all’applicazione al rischio di catastrofe globale (altrimenti noto come rischio catastrofico globale, o RCG). Abbiamo definito una catastrofe globale come un evento che uccide almeno 5 miliardi di persone e abbiamo ipotizzato che il rischio di morire in una catastrofe globale sia uguale per ogni persona. Quindi, data una popolazione mondiale inferiore ai 9 miliardi e a condizione che si verifichi una catastrofe globale, il rischio di ogni americano di morire in quella catastrofe è di almeno 5/9. Riducendo il RCG in questo decennio di 0,1 punti percentuali, il rischio di morte di ogni americano in questo decennio si riduce di almeno 0,055 punti percentuali. Moltiplicando questa cifra per la popolazione statunitense di 330 milioni di abitanti, si ottiene che la riduzione di 0,1 ppm del RCG in questo decennio salva almeno 181 500 vite americane in aspettativa. Se la riduzione del RCG si verificasse quest’anno, avrebbe un valore di almeno 1,27 bilioni di dollari sulla base della cifra più bassa del Dipartimento dei Trasporti (7 milioni di dollari). Ma poiché la riduzione del RCG avverrebbe nell’arco di un decennio, l’analisi costi-benefici richiede uno sconto. Se utilizziamo il tasso di sconto annuale più alto dell’OIRA, pari al 7 %, e supponiamo (in modo prudente) che tutti i costi dei nostri interventi siano pagati in anticipo, mentre la riduzione del RCG si ottiene solo alla fine del decennio, otteniamo il risultato che ridurre il RCG in questo decennio di 0,1pp vale almeno 1,27 bilioni di dollari / 1,0710 = 646 miliardi di dollari. Quindi, con un costo di 400 miliardi di dollari, questi interventi superano senza problemi l’analisi standard dei costi-benefici.r Questo a sua volta suggerisce che il governo degli Stati Uniti dovrebbe finanziare questi interventi. In questo modo si salverebbero vite americane in modo più costo-efficace rispetto a molte altre forme di spesa governativa per il salvataggio di vite umane, come i trasporti e le normative ambientali.

In realtà, possiamo proporre un’argomentazione più solida. Utilizzando una piramide della popolazione statunitense e alcune statistiche sull’aspettativa di vita, possiamo calcolare che circa il 79 % degli anni di vita americani risparmiati prevenendo una catastrofe globale nel 2033 andrebbe agli americani vivi oggi nel 2023.50 Il 79 % di 646 miliardi di dollari è circa 510 miliardi di dollari. Ciò significa che il finanziamento di questa serie di interventi per la riduzione del RCG vale la pena, anche considerando solo i benefici per gli americani vivi oggi.

Ricordiamo che le cifre sopra riportate ipotizzano una riduzione conservativa di 0,1 punti percentuali del RCG come risultato dell’attuazione dell’intera serie di interventi. Riteniamo che una riduzione di 0,5 punti percentuali del RCG sia una stima più ragionevole, nel qual caso il rapporto costi-benefici è superiore a 5. Rendendo più ragionevoli le altre ipotesi, si ottengono rapporti costi-benefici ancora più favorevoli. Utilizzando la cifra primaria del Dipartimento dei Trasporti per il VVS, pari a 11,8 milioni di dollari, e un tasso di sconto annuale del 3 %, il rapporto costi-benefici della suite è superiore a 20.s Gli interventi più costo-efficaci all’interno della suite avranno rapporti costi-benefici ancora più favorevoli.

Vale anche la pena di notare alcune importanti modalità con cui i nostri calcoli fino a questo punto sottovalutano il valore degli interventi di riduzione del RCG. In primo luogo, abbiamo fatto appello solo ai benefici di questi interventi in termini di riduzione del RCG: i benefici di spostare la massa di probabilità da esiti in cui muoiono almeno 5 miliardi di persone verso esiti in cui muoiono pochissime persone. Ma questi interventi diminuirebbero anche il rischio di catastrofi più piccole, in cui muoiono meno di 5 miliardi di persone.t In secondo luogo, il valore della prevenzione delle morti legate alle catastrofi è plausibilmente più alto del valore della prevenzione delle morti dovute al traffico. L’EPA51 e il Tesoro del Regno Unito52 hanno raccomandato di utilizzare un VVS più alto per i rischi di cancro che per i rischi accidentali, per riflettere il fatto che morire di cancro tende a essere più spiacevole che morire in un incidente.53 Suggeriamo che lo stesso punto si applichi alla morte per inverno nucleare e pandemia ingegnerizzata.

Ecco un altro vantaggio degli interventi di riduzione del RCG da noi elencati. Non riducono solo il rischio di morte dei cittadini statunitensi. Riducono anche il rischio di morte dei cittadini di altre nazioni. Questo è un motivo in più per finanziare questi interventi.u Suggerisce anche che il governo degli Stati Uniti potrebbe convincere altre nazioni a condividere i costi degli interventi di riduzione del RCG, nel qual caso il finanziamento di questi interventi diventa un modo ancora più costo-efficace di salvare le vite degli statunitensi. La cooperazione tra le nazioni può anche rendere conveniente per gli Stati Uniti e per il mondo intero spendere di più per ridurre il RCG. Supponiamo, ad esempio, che esista un intervento che costerebbe 1 000 miliardi di dollari e ridurrebbe il RCG di 0,1pp nel prossimo decennio. Si tratta di un intervento troppo costoso per i soli Stati Uniti (almeno in base ai nostri calcoli conservativi), ma varrebbe la pena di finanziare una coalizione di nazioni che accettassero di dividere i costi.

Gli Stati Uniti spendono molto poco per prevenire le catastrofi. Questa conclusione deriva dalla normale analisi costi-benefici. Non è necessario essere lungoterministi per credere che il governo degli Stati Uniti dovrebbe fare molto di più per ridurre il rischio di guerre nucleari, pandemie e disastri legati all’IA. In effetti, anche gli americani egoisti hanno motivo di sperare che il governo degli Stati Uniti aumenti i suoi sforzi per evitare le catastrofi. Gli interventi che raccomandiamo sopra ne valgono la pena, anche considerando solo i benefici per gli americani in vita oggi. Se si considerano i benefici per i cittadini di altre nazioni e per la prossima generazione, questi interventi sono ancora più interessanti. Quindi, gli americani dovrebbero sperare che il governo degli Stati Uniti adotti qualcosa di simile a una politica sulle catastrofi basata sull’ACB: una politica di finanziamento di tutti quegli interventi di riduzione del RCG che superano il test dell’analisi costi-benefici.

Si potrebbe pensare che i lungoterministi dovrebbero essere più ambiziosi: piuttosto che spingere per una politica sulle catastrofi basata sull’ACB, i lungoterministi dovrebbero sollecitare i governi ad adottare una politica lungoterminista forte. Con “politica lungoterminista forte” intendiamo una politica fondata sulla premessa che sarebbe una perdita morale enorme se le generazioni future non esistessero mai.v Tuttavia, sosteniamo che non è così: i lungoterministi dovrebbero sostenere una politica sulle catastrofi basata sull’ACB piuttosto che una politica lungoterminista forte. Questo perché (1) a differenza di una politica lungoterminista forte, una politica basata sull’ACB sarebbe democraticamente accettabile e fattibile da attuare, e (2) ridurrebbe il rischio esistenziale quasi quanto una politica lungoterminista forte.w

Cominciamo con l’accettabilità democratica. Come si è detto, una politica lungoterminista forte imporrebbe in linea di principio oneri estremi alla generazione presente in cambio di riduzioni anche minuscole del rischio esistenziale. Ecco un abbozzo del perché. Se la non esistenza delle generazioni future fosse una perdita morale enorme, allora una catastrofe esistenziale (come l’estinzione umana o il collasso permanente della civiltà) sarebbe estremamente negativa. Per questo vale la pena di ridurre il rischio di catastrofe esistenziale, anche se ciò è estremamente costoso per la generazione presentex.

Ora sosteniamo che una politica lungoterminista forte comporterebbe gravi oneri per la generazione presente non solo in linea di principio, ma anche in pratica. Esistono una serie di interventi per la riduzione del rischio esistenziale che i governi potrebbero attuare solo a costi estremi per chi vive oggi. Ad esempio, i governi potrebbero rallentare lo sviluppo di tecnologie che aumentano il rischio esistenziale (anche quelle che pongono solo rischi minimi) pagando ai ricercatori stipendi elevati perché si dedichino ad altro. I governi potrebbero anche costruire colonie estese e autosufficienti (in luoghi remoti o magari nel sottosuolo) in cui i residenti siano permanentemente isolati dal resto del mondo e addestrati a ricostruire la civiltà in caso di catastrofe. Il governo degli Stati Uniti potrebbe istituire un Nucleic Acid Observatory globale, pagando ad altri Paesi ingenti somme (se necessario) per consentire agli Stati Uniti di monitorare le loro forniture d’acqua alla ricerca di agenti patogeni emergenti. Più in generale, i governi potrebbero sovvenzionare pesantemente gli investimenti, la ricerca e lo sviluppo in modo da incentivare la generazione presente ad aumentare la resilienza della civiltà e a diminuire il rischio esistenziale. Una politica lungoterminista forte cercherebbe di attuare questi e altri interventi in tempi brevi, fattore che ne aumenta il costo. Queste spese richiederebbero a loro volta un aumento delle tasse sui cittadini attuali (in particolare delle tasse sui consumi), nonché il taglio di forme di spesa pubblica che hanno scarso effetto sul rischio esistenziale (come la sicurezza sociale, molti tipi di cure mediche e finanziamenti per parchi pubblici, arte, cultura e sport). Questi cambiamenti di bilancio sarebbero onerosi per chi è vivo oggi. Anche una regolamentazione molto cauta dello sviluppo tecnologico imporrebbe degli oneri. Potrebbe significare che i cittadini attuali non possono usufruire di tecnologie che migliorerebbero e allungherebbero la loro vita, come i beni di consumo e le cure per le malattie.

Quindi, una politica lungoterminista forte sarebbe democraticamente inaccettabile, nel senso che non potrebbe essere adottata e mantenuta da un governo democratico. Se un governo cercasse di adottare una politica lungoterminista forte, perderebbe il sostegno della maggior parte dei suoi cittadini. Ci sono chiare obiezioni morali contro il perseguimento di politiche democraticamente inaccettabili, ma anche mettendole da parte, convincere i governi ad adottare una forte politica lungoterminista non è fattibile. È molto improbabile che gli sforzi in questa direzione abbiano successo.

Una politica sulle catastrofi basata sull’ACB, invece, sarebbe democraticamente accettabile. Questo tipo di politica non imporrebbe pesanti oneri alla generazione presente. Poiché l’analisi costi-benefici si basa in gran parte sulla disponibilità a pagare dei cittadini, le politiche guidate dall’analisi costi-benefici tendono a non chiedere ai cittadini di pagare molto più di quanto sia nel loro interesse. E data l’attuale mancanza di spesa per la prevenzione delle catastrofi, il passaggio dallo status quo a una politica guidata dall’ACB è quasi certamente positivo per i cittadini statunitensi in vita. Questo è un motivo per pensare che convincere il governo degli Stati Uniti ad adottare una politica basata sulle ACB sia particolarmente fattibile. Un altro motivo è che l’analisi costi-benefici è già uno strumento standard nel processo decisionale degli Stati Uniti.y Sostenere una politica basata sull’ACB non significa chiedere ai governi di adottare una procedura decisionale radicalmente nuova. Significa solo chiedere loro di estendere una procedura decisionale standard in un ambito in cui finora è stata poco utilizzata.

Naturalmente, convincere i governi ad adottare una politica sulle catastrofi basata sull’ACB non è cosa semplice. Un primo ostacolo è di tipo psicologico.54 Molti di noi hanno difficoltà a comprendere la probabilità e l’entità di una catastrofe globale. Un’altra è che la riduzione del RCG è un problema di azione collettiva per gli individui. Sebbene un mondo più sicuro sia nell’interesse di molti, lavorare per un mondo più sicuro è nell’interesse di pochi. Fare ciò significa sopportare una gran parte dei costi e ottenere solo una piccola parte dei benefici.z Anche i politici e le autorità di regolamentazione non hanno incentivi a sostenere interventi per la riduzione del RCG (come hanno fatto con gli interventi sul clima nei decenni precedenti). Data la diffusa ignoranza dei rischi, è poco probabile che le richieste di tali interventi ottengano il favore dell’opinione pubblica.

Tuttavia, queste barriere possono essere superate. Coloro che sono disposti a sopportare i costi per il bene degli altri possono usare il loro tempo e il loro denaro per rendere importante la prospettiva di una catastrofe globale, promuovendo così il sostegno pubblico per gli interventi di riduzione del RCG e inserendoli nei programmi politici. I lungoterministi, che si preoccupano della generazione presente e di quelle future, sono adatti a svolgere questo ruolo per spingere i governi ad adottare una politica sulle catastrofi basata sull’ACB. Se si impegnano in questo senso, hanno buone probabilità di successo.

Passiamo ora al secondo punto: convincere il governo degli Stati Uniti ad adottare una politica sulle catastrofi esistenziali basata sull’ACB ridurrebbe il rischio esistenziale quasi quanto fargli adottare una politica lungoterminista forte. Questo per due motivi. Il primo è che, al margine attuale, gli obiettivi primari di una politica basata sull’ACB e di una politica lungoterminista forte sono sostanzialmente identici. Il secondo è che l’aumento della spesa per la prevenzione delle catastrofi esistenziali produce rendimenti decrescenti in termini di riduzione del rischio esistenziale.

Cominciamo con l’allineamento sostanziale. L’obiettivo principale di una politica sulle catastrofi basata sull’ACB è salvare vite umane sul breve periodo. L’obiettivo primario di una politica lungoterminista forte è la riduzione del rischio esistenziale. Nel mondo attuale, questi obiettivi sono allineati: molti dei migliori interventi per ridurre il rischio esistenziale sono anche interventi costo-efficaci per salvare vite sul breve periodo. Prendiamo ad esempio l’intelligenza artificiale. Secondo Ord e molti altri lungoterministi, il rischio legato all’IA costituisce una parte consistente del rischio esistenziale totale di questo secolo e potrebbe essere ridotto in modo significativo lavorando sulla sicurezza e sulla governance dell’IA.55 Ciò pone questo lavoro in cima alla lista delle priorità di molti lungoterministi. Abbiamo sostenuto in precedenza che una politica basata sull’ACB finanzierebbe anche questo lavoro, poiché si tratta di un modo costo-efficace di salvare vite umane nel breve termine. Lo stesso vale per le pandemie. Gli interventi per contrastare potenziali pandemie occupano un posto di rilievo nella lista delle priorità dei lungoterministi, e anche questi interventi verrebbero implementati da una politica basata sull’ACB.

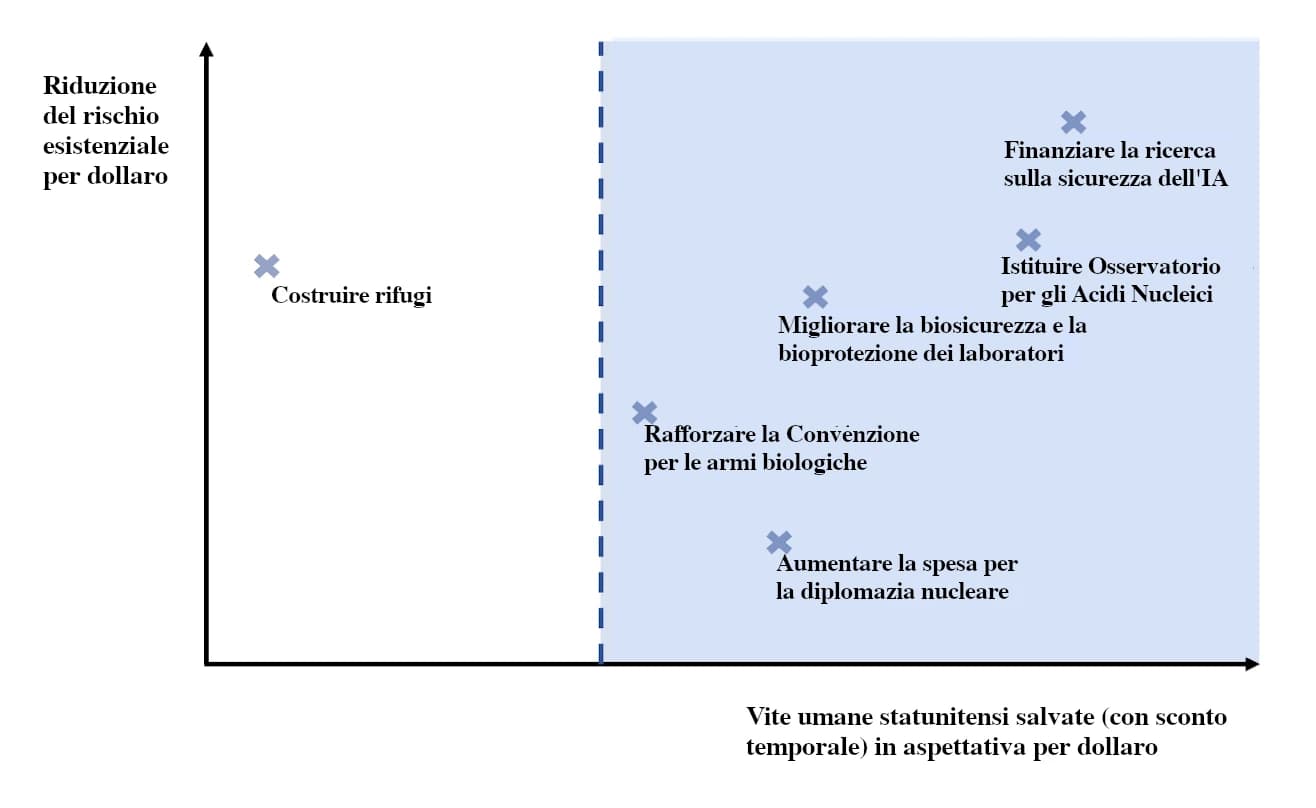

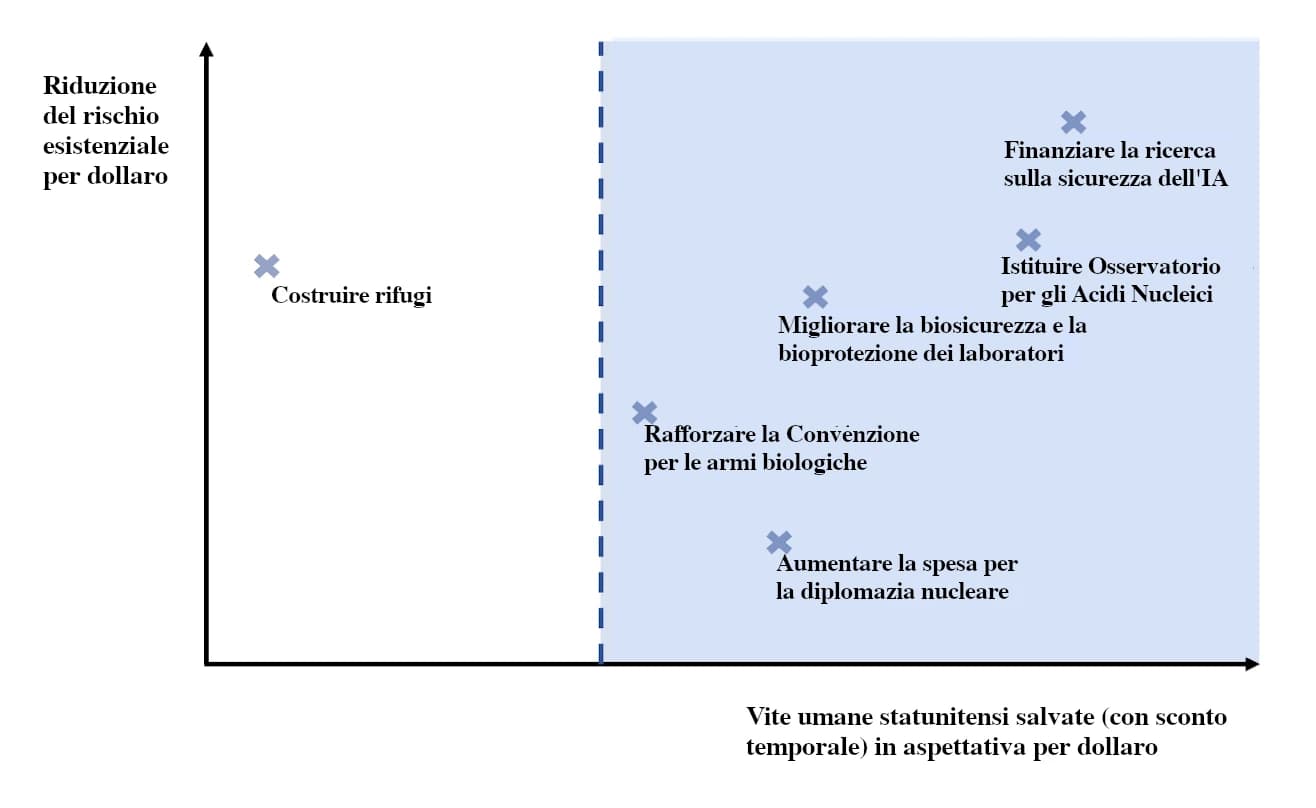

L’allineamento tra una politica basata sull’ACB e una politica lungoterminista forte è illustrato dal grafico seguente. L’asse delle ascisse rappresenta le vite salvate negli Stati Uniti (scontate in base al futuro lontano in cui vengono salvate) in aspettativa per dollaro. L’asse y rappresenta la riduzione del rischio esistenziale per dollaro. Gli interventi a destra della linea blu sarebbero finanziati da una politica sulle catastrofi basata sull’ACB. L’esatta posizione di ogni intervento è provvisoria e non ha importanza, e in ogni caso il grafico non è in scala. La cosa importante è che una politica basata sull’ACB finanzierebbe molti dei migliori interventi per la riduzione del rischio esistenziale.

Questo è l’allineamento fondamentale tra una politica ACB e una politica lungoterminista forte. Passiamo ora a tre differenze potenzialmente significative. La prima è che una politica lungoterminista forte finanzierebbe quelli che chiamiamo beni lungoterministi puri: beni che non apportano grandi benefici alle persone attuali, ma migliorano le prospettive dell’umanità sul lungo periodo, inclusi i rifugi per aiutare l’umanità a riprendersi dalle catastrofi. La seconda differenza è che una politica lungoterminista forte spenderebbe molto di più per prevenire le catastrofi rispetto a una politica basata sull’ACB. Oltre agli interventi giustificati da quest’ultima, una politica lungoterminista forte finanzierebbe anche gli interventi di prevenzione delle catastrofi che sono troppo costosi e non supererebbero l’analisi costi-benefici. La terza differenza riguarda i rischi nucleari. Il rischio di una guerra nucleare su larga scala è significativamente più alto del rischio che una guerra nucleare costituisca una catastrofe esistenziale (5 % contro 0,1 % in questo secolo, secondo Ord). In parte per questo motivo, gli interventi per ridurre il rischio nucleare hanno un buon rapporto costo-efficacia quando si tratta di salvare vite umane nel breve periodo, ma non altrettanto quando si tratta di ridurre il rischio esistenziale.aa Ciò rende questi interventi una priorità relativamente più bassa per una politica lungoterminista forte di quanto non lo siano per una politica basata sull’ACB. Mantenendo fisso il budget per le catastrofi giustificato dall’analisi costi-benefici, una politica lungoterminista forte probabilmente sposterebbe parte dei finanziamenti dagli interventi nucleari a quelli per l’IA e le pandemie che non superano il test dell’analisi costi-beneficiab.

Per ora mettiamo da parte i beni lungoterministi puri. Ne parliamo nella prossima sezione. Consideriamo invece il fatto che una politica lungoterminista forte spenderebbe molto di più per prevenire le catastrofi (soprattutto legate all’IA e alle catastrofi biologiche) rispetto a una politica basata sull’ACB. Secondo noi questa spesa extra non farebbe una differenza così significativa per il rischio esistenziale, perché l’aumento della spesa per prevenire le catastrofi produce rendimenti decrescenti in termini di riduzione del rischio esistenziale. Ciò è dovuto a due ragioni principali. La prima è che gli interventi più promettenti per la riduzione del rischio esistenziale, come ad esempio la sicurezza legata all’IA e la governance dell’IA, il Nucleic Acid Observatory e il miglioramento della biosicurezza superano l’analisi costi-benefici. Gli interventi di prevenzione delle catastrofi che non superano il test dell’analisi costi-benefici non sono altrettanto efficaci nel ridurre il rischio esistenziale.

Ecco una seconda ragione per aspettarsi che l’aumento della spesa produca rendimenti decrescenti in termini di riduzione del rischio esistenziale: molti interventi si indeboliscono a vicenda, vale a dire che rendono meno efficaci altri interventi, cosicché la riduzione totale del rischio esistenziale ottenuta con il finanziamento di alcune serie di interventi è inferiore alla somma della riduzione del rischio esistenziale ottenuta con il finanziamento di ogni singolo intervento. Vediamone un esempio: a parte una piccola complicazione, possiamo scomporre il rischio esistenziale derivante dagli agenti patogeni ingegnerizzati in due fattori, il rischio che un agente patogeno ingegnerizzato infetti più di 1 000 persone e il rischio di una catastrofe esistenziale se un agente patogeno ingegnerizzato infetta più di 1 000 persone.ac Supponiamo (a titolo puramente illustrativo) che ogni rischio sia del 10 % in questo decennio, che incentivare i ricercatori biomedici del mondo a fare ricerca più sicura dimezzi il primo rischio e che istituire un Nucleic Acid Observatory (NAO) dimezzi il secondo rischio. In assenza di interventi, il rischio esistenziale per questo decennio derivante da agenti patogeni ingegnerizzati è dell’1 %. Il solo incentivare la ricerca sicura ridurrebbe il rischio esistenziale dello 0,5 %. La sola istituzione di un NAO ridurrebbe il rischio esistenziale dello 0,5 %. Ma incentivare la ricerca sicura dopo l’istituzione di un NAO riduce il rischio esistenziale soltanto dello 0,25 %. Più in generale, l’efficacia degli interventi di riduzione del rischio esistenziale che non superano il test dell’analisi costi-benefici sarebbe sostanzialmente compromessa da tutti quegli interventi che superano il test dell’analisi costi-benefici.

Al momento, il mondo spende molto poco per prevenire le catastrofi globali. Gli Stati Uniti hanno speso circa 3 miliardi di dollari per la biosicurezza nel 2019,56 e (nonostante il campanello d’allarme fornito da COVID-19) i finanziamenti per la prevenzione di future pandemie non sono aumentati di molto da allora.ae Gran parte di questa spesa non è adatta a combattere le minacce biologiche più estreme. La spesa per la riduzione del RCG legato all’IA è inferiore a 100 milioni di dollari all’anno.af Per i governi, quindi, ci sono molte opportunità a portata di mano: data l’attuale mancanza di spesa, il passaggio a una politica sulle catastrofi basata sull’ACB ridurrebbe significativamente il rischio esistenziale. I governi potrebbero ridurre ulteriormente il rischio esistenziale passando a una politica lungoterminista forte, ma questa ulteriore riduzione sarebbe relativamente piccola. Lo stesso vale per lo spostamento dei finanziamenti dal rischio nucleare a quello legato all’IA e alle pandemie, mantenendo fisso il livello di spesa per la prevenzione delle catastrofi giustificato dall’analisi costi-benefici. Questo spostamento avrebbe solo un piccolo effetto sul rischio esistenziale, perché i migliori interventi per ridurre i rischi legati all’IA e alle pandemie sarebbero già stati finanziati da una politica basata sull’ACB.

E, come già detto, la cooperazione internazionale renderebbe ancora più interventi preventivi delle catastrofi abbastanza costo-efficaci da superare l’analisi costi-benefici. Alcuni di questi interventi aggiuntivi avrebbero anche effetti non banali sul rischio esistenziale. Si pensi al cambiamento climatico. Alcuni interventi sul clima sono troppo costosi per essere finanziati unilateralmente nell’interesse di qualsiasi nazione, ma valgono la pena di essere finanziati da una coalizione di nazioni che accettano di coordinarsi. La transizione dai combustibili fossili alle fonti di energia rinnovabili è un esempio. Il cambiamento climatico è anche un fattore di rischio esistenziale, ovvero un fattore che aumenta il rischio esistenziale. Oltre a rappresentare un piccolo rischio di estinzione umana o di collasso permanente della civiltà, il cambiamento climatico comporta un rischio indiretto significativo. Rischia di esacerbare i conflitti internazionali e di spingere l’umanità a perseguire soluzioni tecnologiche rischiose. Un cambiamento climatico estremo danneggerebbe anche la nostra resilienza e ci renderebbe più vulnerabili ad altre catastrofi. Quindi, oltre agli altri benefici, la mitigazione del cambiamento climatico riduce il rischio esistenziale. Poiché un maggior numero di interventi sul clima supera l’analisi costi-benefici se le nazioni accettano di coordinarsi, questo tipo di cooperazione internazionale ridurrebbe ulteriormente il divario tra il rischio esistenziale con una politica delle catastrofi basata sull’ACB e una politica lungoterminista forte.

Rimane una differenza potenzialmente importante tra una politica sulle catastrofi basata sull’ACB e una politica lungoterminista forte: una politica lungoterminista forte fornirà finanziamenti significativi per quelli che chiamiamo beni lungoterministi puri. Questi beni sono definiti come beni che non portano grandi benefici alla generazione presente, ma migliorano le prospettive dell’umanità sul lungo periodo. Essi includono in particolare i rifugi: grandi strutture ben attrezzate, simili a bunker, progettate per aiutare gli occupanti a sopravvivere a catastrofi future e a ricostruire in seguito la civiltà.57 Potrebbe sembrare che una politica sulle catastrofi basata sull’ACB non preveda alcun finanziamento per i beni lungoterministi puri, perché non hanno un rapporto di costo-efficacia particolarmente alto quando si tratta di salvare vite umane nel futuro prossimo. In caso di grave catastrofe, i rifugi salverebbero al massimo una piccola parte delle persone oggi in vita. Ma una politica lungoterminista forte investirebbe nei rifugi, perché ridurrebbero significativamente il rischio esistenziale. Anche un gruppo relativamente piccolo di sopravvissuti potrebbe rimettere l’umanità in carreggiata, in tal caso, caso una catastrofe esistenziale, ovvero la distruzione permanente del potenziale a lungo termine dell’umanità, sarebbe stata evitata. Poiché una politica lungoterminista forte fornirebbe finanziamenti per i rifugi, potrebbe sembrare che l’adozione di una politica lungoterminista forte riduca il rischio esistenziale in misura significativamente maggiore rispetto all’adozione di una politica basata sull’ACB.

Tuttavia, anche questa differenza tra una politica basata sull’ACB e una politica lungoterminista forte non deve per forza essere così grande. Questo perché l’analisi costi-benefici dovrebbe incorporare (e sta iniziando a farlo) la disponibilità dei cittadini a pagare per mantenere i loro impegni morali: quella che chiameremo la loro disponibilità altruistica a pagare (DAAP). Posner e Sunstein offrono argomentazioni in tal senso.58 Essi notano che i cittadini hanno diversi impegni morali: nei confronti del mondo naturale, degli animali non umani, dei cittadini di altre nazioni, delle generazioni future, ecc. Posner e Sunstein sostengono che il modo migliore per misurare queste perdite è la disponibilità dei cittadini a pagare per mantenere i loro impegni morali, e che questa disponibilità dovrebbe essere inclusa nelle analisi costo-benefici delle normative proposte.59 ag Posner e Sunstein notano anche che esistono precedenti normativi e legali per farlo.60 ah

E qui, a nostro avviso, è dove il lungoterminismo dovrebbe entrare nella politica governativa sulle catastrofi. I lungoterministi dovrebbero far valere il loro punto di vista, aumentando così la DAAP dei cittadini per i beni lungoterministi puri, come i rifugi.ai Quando i cittadini sono disposti a pagare per questi beni, i governi dovrebbero finanziarli.

Sebbene sia difficile prevedere l’adozione di nuovi movimenti etici,61 abbiamo motivo di essere ottimisti riguardo a questo tipo di diffusione del lungoterminismo. Un recente sondaggio suggerisce che molte persone hanno intuizioni morali che potrebbero orientarle verso una forma debole di lungoterminismo: gli intervistati tendevano a giudicare che è bene creare persone felici.62 Un altro sondaggio indica che il semplice fatto di rendere il futuro evidente ha un effetto marcato sulle opinioni delle persone riguardo all’estinzione umana. Quando gli intervistati sono stati invitati a considerare le conseguenze a lungo termine, la percentuale di persone che giudicavano l’estinzione umana come estremamente negativa rispetto alla quasi-estinzione è passata dal 23 % al 50 %.63 E quando gli intervistati sono stati invitati a ipotizzare che la vita nel futuro prossimo sarebbe stata molto migliore di quella attuale, il numero è salito al 77 %.64 Nell’arco di circa sei decenni, l’ambientalismo è passato dall’essere un movimento marginale a una delle principali priorità morali del nostro tempo. Come il lungoterminismo, è stato motivato in gran parte dalla preoccupazione per le generazioni future. Gli argomenti dei lungoterministi sono già stati convincenti per molte persone e questi fattori suggeriscono che potrebbero esserlo per molte altre.

Anche una piccola DAAP per i beni lungoterministi puri potrebbe avere un effetto significativo sul rischio esistenziale. Se i cittadini statunitensi sono disposti a contribuire in media con soli 5 dollari all’anno, una politica basata sull’ACB che incorpori la DAAP giustifica una spesa fino a 1,65 miliardi di dollari all’anno per i beni lungoterministi puri, sufficiente a costruire un gran numero di rifugi. Naturalmente, anche in uno scenario in cui tutti i cittadini statunitensi ascoltano gli argomenti dei lungoterministi, una politica basata sull’ACB fornirà meno finanziamenti per i beni lungoterministi puri rispetto a una politica lungoterminista forte. Ma, come nel caso degli interventi di prevenzione delle catastrofi, sembra probabile che la riduzione marginale del rischio esistenziale diminuisca bruscamente all’aumentare della spesa per i beni lungoterministi puri: così bruscamente che passare al livello di spesa per i beni lungoterministi puri giustificato dalla DAAP dei cittadini ridurrebbe il rischio esistenziale quasi quanto passare al livello di spesa giustificato dalla politica lungoterminista forte. Questo vale soprattutto se più nazioni si offrono di finanziare beni lungoterministi puri in linea con la DAAP dei loro cittadini.

C’è un ultimo punto da considerare. Si potrebbe pensare che sia vero solo al margine attuale e in pubblico che i lungoterministi dovrebbero spingere i governi ad adottare una politica sulle catastrofi guidata dall’analisi costi-benefici e dalla disponibilità altruistica a pagare. Una volta finanziati tutti gli interventi giustificati dall’ACB e dalla DAAP, i lungoterministi dovrebbero fare pressioni affinché i governi spendano ancora di più per prevenire le catastrofi. E nel frattempo, dovrebbero chiedere in privato ai governi di finanziare interventi di riduzione del rischio esistenziale che vadano oltre l’ACB e la DAAP.

Noi non siamo d’accordo. I lungoterministi possono cercare di aumentare i finanziamenti governativi per la prevenzione delle catastrofi presentando argomenti lungoterministi e aumentando così la DAAP dei cittadini, ma non dovrebbero sollecitare i governi a discostarsi da una politica sulle catastrofi basata sull’ACB e la DAAP. Al contrario, i lungoterministi dovrebbero impegnarsi il più possibile ad agire in conformità con una politica basata sull’ACB e la DAAP nella sfera politica. Il motivo è semplice: i lungoterministi hanno ragioni morali per rispettare le preferenze dei loro concittadini.

Per vedere un altro motivo, notiamo innanzitutto che i lungoterministi che lavorano per migliorare la politica governativa in materia di catastrofi potrebbero rappresentare un vantaggio per tutti. La generazione presente ne beneficia perché i lungoterministi risolvono il problema dell’azione collettiva: lavorano per implementare interventi che riducono in modo costo-efficace il rischio di morire in una catastrofe. Le generazioni future ne beneficiano perché questi interventi riducono anche il rischio esistenziale. Ma allo stato attuale la generazione presente potrebbe temere che i lungoterministi si spingano troppo oltre. Se gli venisse concesso un potere irresponsabile, i lungoterministi potrebbero cercare di usare la macchina governativa per imporre oneri alla generazione presente in nome di ulteriori benefici per le lontane generazioni future. Queste preoccupazioni potrebbero portare all’emarginazione del lungoterminismo e quindi a un risultato peggiore sia per le generazioni presenti che per quelle future.

La soluzione migliore è il compromesso e l’impegno.aj Una politica basata sull’ACB e la DAAP (e fondata sulle preferenze dei cittadini) è accettabile per moltissime persone. Di conseguenza, i lungoterministi che si impegnano ad agire in conformità con una politica basata sull’ACB e la DAAP rendono possibile un accordo che è significativamente migliore dello status quo, sia per i lungoterministi che per la generazione presente. Inoltre, la cooperazione offre altri vantaggi. Per esempio, aiuta a evitare inutili conflitti in cui i gruppi fanno pressione per politiche opposte, con una parte sostanziale delle risorse che spendono che si annullano a vicenda.65 Con una politica basata sull’ACB e la DAAP in atto, quelle risorse possono invece essere spese per interventi che sono interessanti per tutte le parti.

Ci sono molti modi in cui i lungoterministi possono aumentare e dimostrare il loro impegno verso questo tipo di politica di compromesso in cui vincono tutti. Possono parlarne a favore ora e agire in accordo con essa nella sfera politica. Possono anche sostenere gli sforzi per incorporare un criterio basato sull’ACB e la DAAP nel processo decisionale del governo (attraverso ordini esecutivi, statuti normativi e leggi), garantendo così che i governi non spendano né troppo né troppo poco per i benefici alle generazioni future. I lungoterministi possono anche guadagnarsi la reputazione di cooperare bene con gli altri, sostenendo interventi e istituzioni che siano di interesse per un ampio spettro di persone. In questo modo, i lungoterministi rendono possibile una forma di cooperazione che è sostanzialmente vantaggiosa sia per la generazione presente che per il futuro a lungo termine.

I governi dovrebbero spendere molto di più per scongiurare le minacce della guerra nucleare, delle pandemie ingegnerizzate e dell’IA. Questa conclusione deriva dalla normale analisi costi-benefici. Non è necessario dare per scontato il lungoterminismo, né che le generazioni future siano importanti. In realtà, anche gli americani del tutto egoisti hanno motivo di sperare che il governo degli Stati Uniti adotti una politica sulle catastrofi guidata dall’analisi costi-benefici.

I lungoterministi dovrebbero spingere per un obiettivo simile: una politica governativa sulle catastrofi guidata dall’analisi costi-benefici e dalla disponibilità altruistica a pagare dei cittadini. Questa politica è realizzabile e sarebbe democraticamente accettabile. Inoltre, ridurrebbe il rischio esistenziale in misura quasi uguale a una politica lungoterminista forte. Questo vale soprattutto se i lungoterministi riusciranno a fare del futuro a lungo termine una delle principali priorità morali del nostro tempo e se la disponibilità altruistica dei cittadini a pagare per i benefici del futuro a lungo termine aumenterà di conseguenza. I lungoterministi dovrebbero impegnarsi ad agire nella sfera politica secondo una politica basata sull’ACB e la DAAP. Questo impegno contribuirebbe a realizzare una politica sulle catastrofi molto migliore dello status quo, sia per la generazione presente che per il futuro a lungo termine.

Per i commenti utili, ringraziamo Mackenzie Arnold, Tomi Francis, Jakob Graabak, Hannah Lovell, Andreas Schmidt, Philip Trammell, Risto Uuk, Nikhil Venkatesh, un revisore anonimo della Oxford University Press e i partecipanti al 10° Oxford Workshop sulla ricerca sulle priorità globali.