Perché l’allineamento dell’IA potrebbe essere difficile con il moderno deep learning

Holden ha precedentemente menzionato l’idea che i sistemi avanzati di IA (ad esempio PASTA) possano sviluppare obiettivi pericolosi che li portino a ingannare o a privare del potere gli esseri umani. Questa potrebbe sembrare una preoccupazione piuttosto fuori dal comune. Perché dovremmo programmare un’intelligenza artificiale che vuole farci del male? Ma penso che in realtà potrebbe essere un problema difficile da evitare, soprattutto se l’IA avanzata viene sviluppata utilizzando il deep learning (spesso usato per sviluppare IA all’avanguardia oggi).

Nel deep learning, non programmiamo a mano un computer per svolgere un compito. In parole povere, cerchiamo un programma per computer (chiamato modello) che svolga bene il compito. Di solito sappiamo molto poco del funzionamento interno del modello che otteniamo, solo che sembra fare un buon lavoro. È meno simile alla costruzione di una macchina e più simile all’assunzione e alla formazione di un dipendente.

E proprio come i dipendenti umani possono avere molte motivazioni diverse per svolgere il loro lavoro (dal credere nella missione dell’azienda, al piacere del lavoro quotidiano, al desiderio di guadagnare denaro), anche i modelli di deep learning possono avere molte “motivazioni” diverse che portano tutte a ottenere buone prestazioni in un compito. E poiché non sono umani, le loro motivazioni potrebbero essere molto strane e difficili da prevedere, come se fossero dipendenti alieni.

Stiamo già iniziando a vedere le prime prove del fatto che i modelli a volte perseguono obiettivi che i loro progettisti non avevano previsto ( e ). Al momento non sussiste un vero pericolo, ma se continuerà a verificarsi con modelli molto potenti potremmo ritrovarci in una situazione in cui la maggior parte delle decisioni importanti (compreso il tipo di a cui puntare) sono prese dai modelli senza tenere in gran conto i valori umani.

Il problema dell’allineamento del deep learning è il problema di garantire che i modelli avanzati di deep learning non perseguano obiettivi pericolosi. Nel resto di questo post, mi occuperò di:

Questa sezione descrive un’analogia per cercare di illustrare in modo intuitivo perché evitare il disallineamento in un modello molto potente sembra difficile. Non è un’analogia perfetta; cerca solo di trasmettere alcune intuizioni.

Immaginate di essere un bambino di otto anni a cui genitori hanno lasciato un’azienda da mille miliardi di dollari e nessun adulto fidato che vi faccia da guida nel mondo. Dovete assumere un adulto intelligente che diriga la vostra azienda come amministratore delegato, gestisca la vostra vita come farebbe un genitore (ad esempio, decidere la scuola, dove vivere, quando andare dal dentista) e amministri il vostro immenso patrimonio (ad esempio, decidere dove investire il vostro denaro).

Dovete assumere questi adulti sulla base di una prova di lavoro o di un colloquio che vi viene proposto. Non potete vedere nessun curriculum, non potete fare controlli sulle referenze, ecc. Poiché siete così ricchi, tonnellate di persone si candidano per i motivi più disparati.

Il vostro gruppo di candidati comprende:

Poiché avete otto anni, probabilmente non sarete in grado di progettare il giusto tipo di test di lavoro, quindi potreste facilmente ritrovarvi con un Adulatore o un Opportunista:

Qualunque cosa vi venga in mente, sembra che sia facile finire con l’assumere e dare tutto il controllo funzionale a un Adulatore o a un Opportunista. Quando sarete adulti e vi renderete conto dell’errore commesso, è molto probabile che non avrete più un soldo e non potrete più rimediare.

In questa analogia:

Nella prossima sezione, approfondirò il funzionamento dell’deep learning e spiegherò perché gli Adulatori e gli Opportunisti potrebbero nascere dal tentativo di addestrare un modello di deep learning potente come un PASTA.

In questa sezione, collegherò l’analogia ai processi di addestramento reali per il deep learning:

Questa è una spiegazione semplificata che dà un’idea generale di cosa sia il deep learning. Per una spiegazione più dettagliata e tecnicamente accurata, vedi questo post.

Il deep learning consiste essenzialmente nel cercare il modo migliore per organizzare un modello neurale, che è come un “cervello” digitale con molti neuroni digitali collegati tra loro con connessioni di forza variabile, per fargli svolgere bene un certo compito. Questo processo si chiama addestramento e comporta molte prove ed errori.

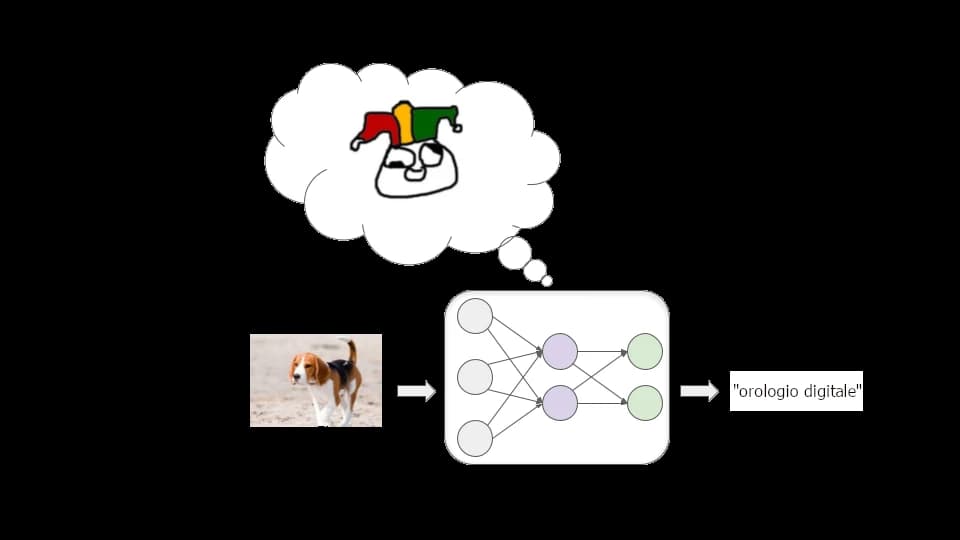

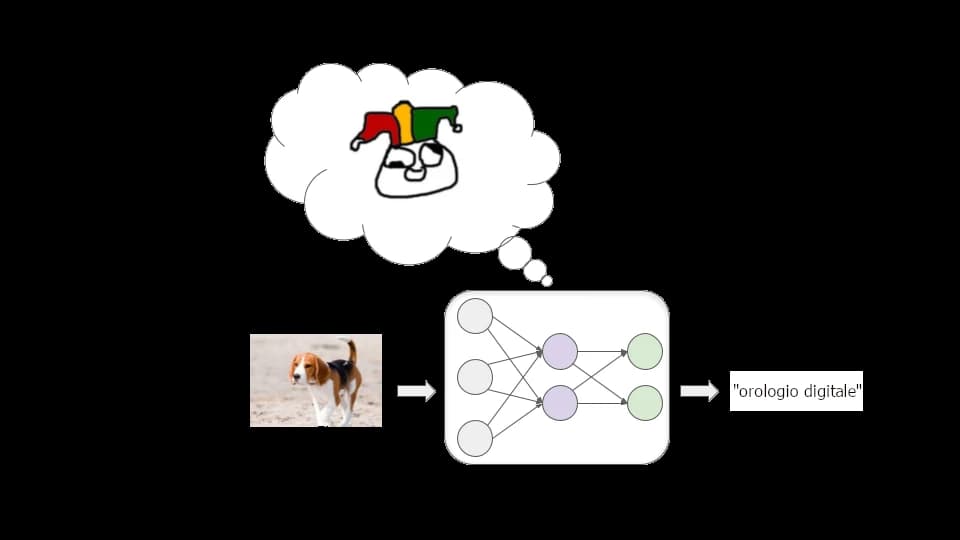

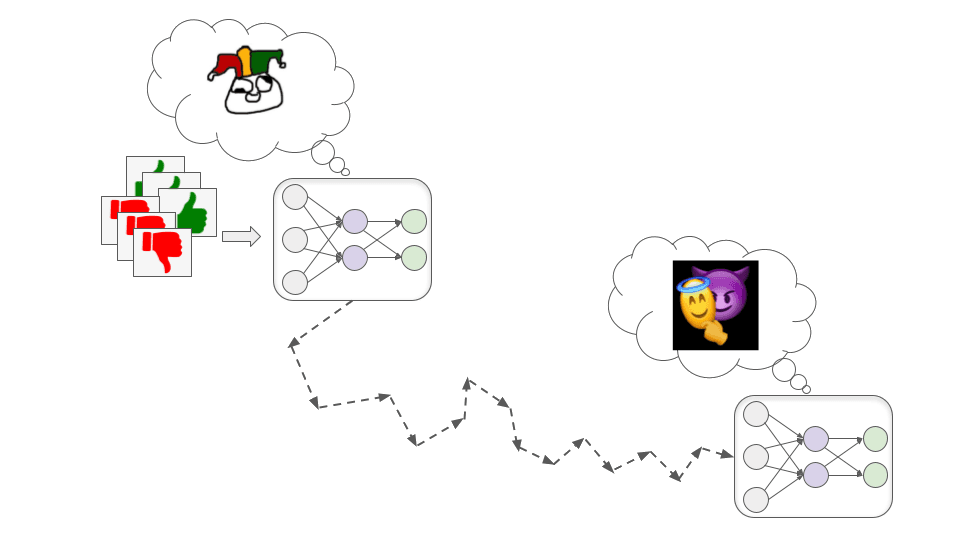

Immaginiamo di voler addestrare un modello per classificare bene le immagini. Iniziamo con una rete neurale in cui tutte le connessioni tra i neuroni hanno una forza casuale. Questo modello etichetta le immagini in modo selvaggiamente errato:

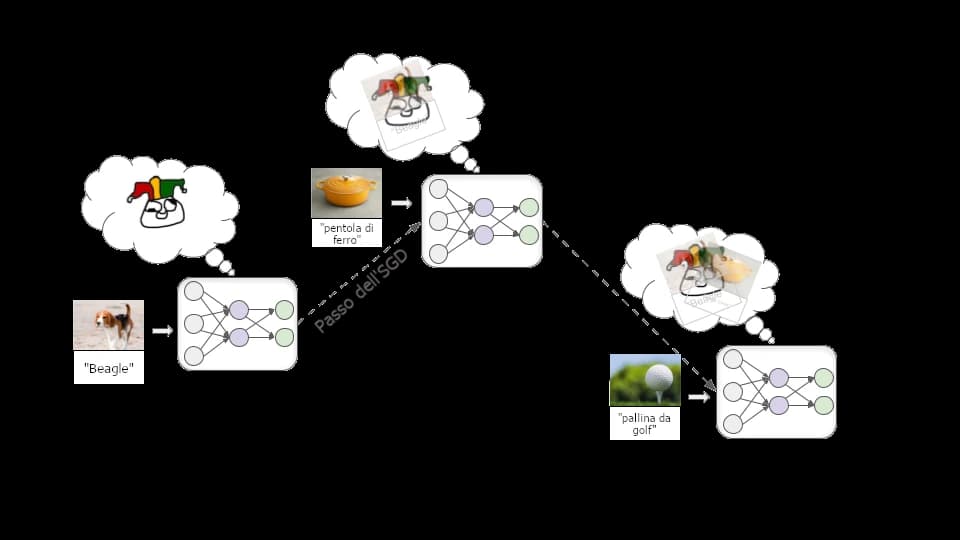

Poi inseriamo un gran numero di immagini di esempio, lasciando che il modello provi ripetutamente a etichettare un esempio e poi gli indichi l’etichetta corretta. In questo modo, le connessioni tra i neuroni vengono modificate ripetutamente attraverso un processo chiamato discesa stocastica del gradiente (SGD). A ogni esempio, l’SGD rafforza leggermente alcune connessioni e ne indebolisce altre per migliorare un po’ le prestazioni:

Dopo aver inserito milioni di esempi, avremo un modello che farà un buon lavoro di etichettatura di immagini simili in futuro.

Oltre alla classificazione delle immagini, il deep learning è stato utilizzato per produrre modelli che riconoscono le voci, giocano a giochi da tavolo e videogiochi, generano testi, immagini e musica abbastanza realistici, controllano robot e altro ancora. In ogni caso, iniziamo con un modello di rete neurale connesso in modo casuale e poi:

Questi passaggi vengono ripetuti milioni o miliardi di volte fino a quando non si ottiene un modello che otterrà una ricompensa elevata su esempi futuri simili a quelli visti durante l’addestramento.

Questo tipo di processo di addestramento non ci dà molte informazioni su come il modello ottiene buone prestazioni. Di solito ci sono più modi per ottenere buone prestazioni e il modo in cui l’SGD le trova spesso non è intuitivo.

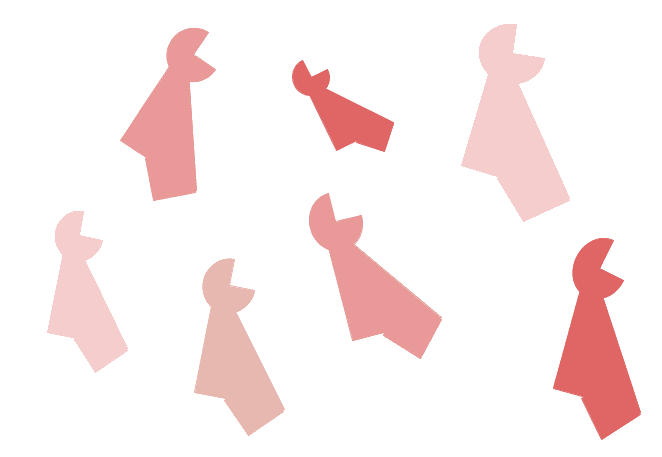

Illustriamo con un esempio. Immaginate che vi dica che questi oggetti sono tutti “thneebs”:

Quale di questi due oggetti è un thneeb?

Probabilmente, intuitivamente, si pensa che l’oggetto a sinistra sia il thneeb, perché si è abituati a considerare la forma più importante del colore per determinare l’identità di un oggetto. Ma i ricercatori hanno scoperto che le reti neurali di solito partono dal presupposto opposto. Una rete neurale addestrata su un gruppo di thneeb rossi probabilmente etichetterebbe l’oggetto sulla destra come un thneeb.

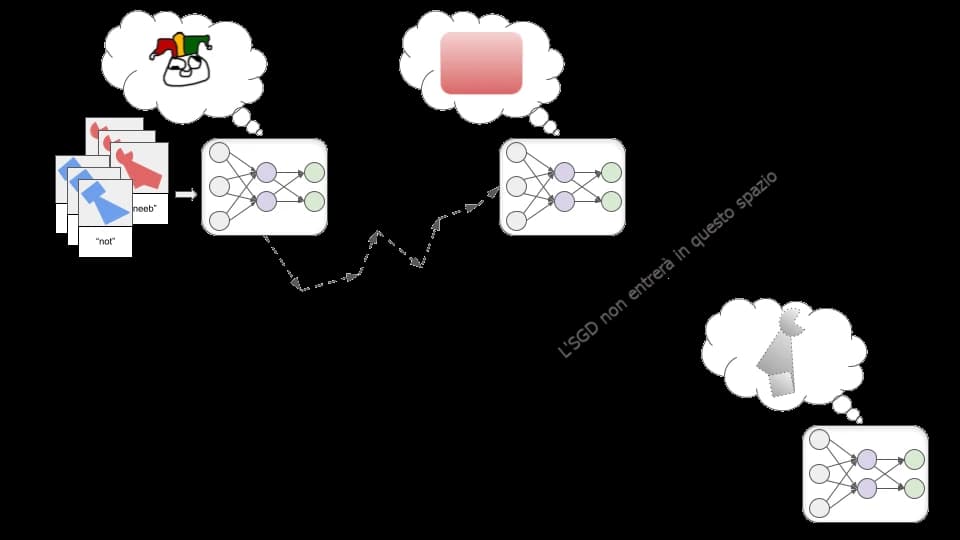

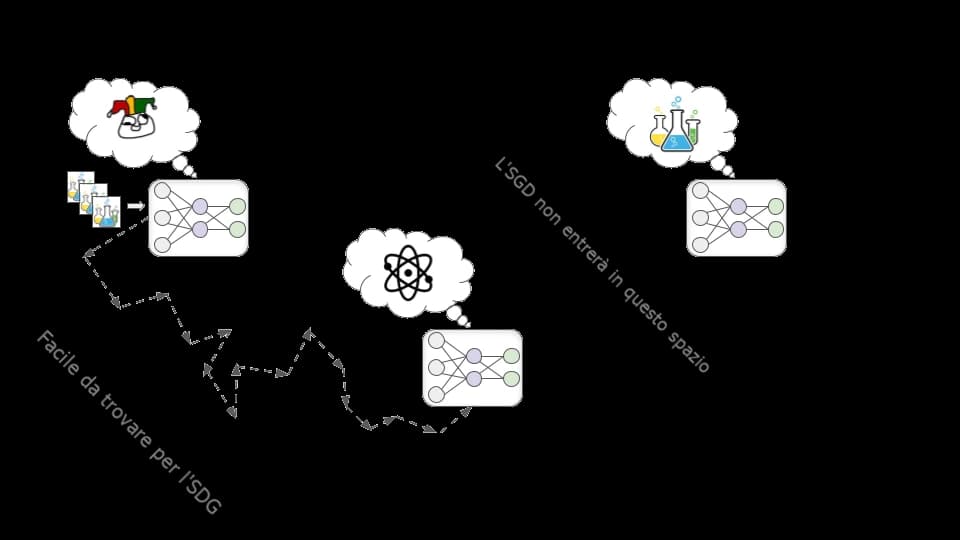

Non sappiamo bene perché, ma per qualche motivo è più “facile” per l’SGD trovare un modello che riconosca un particolare colore piuttosto che uno che riconosca una particolare forma. E se l’SGD trova prima il modello che riconosce perfettamente la sfumatura rossa, non c’è molto altro incentivo a “continuare a cercare” il modello che riconosce la forma, dato che il modello che riconosce il rosso avrà un’accuratezza perfetta sulle immagini viste durante l’addestramento:

Se i programmatori si aspettavano di ottenere il modello di riconoscimento delle forme, potrebbero considerarlo un fallimento. Ma è importante riconoscere che non ci sarebbe stato alcun errore o fallimento logicamente deducibile se avessimo ottenuto il modello che riconosce il rosso invece del modello che riconosce la forma. Si tratta solo del fatto che il processo che abbiamo messo in atto ha presupposti di partenza diversi da quelli che abbiamo nella nostra testa. Non possiamo dimostrare che le ipotesi umane siano corrette.

Questo genere di cose accade spesso nel moderno deep learning. Premiamo i modelli che ottengono buone prestazioni sperando che siano in grado di individuare i modelli che ci sembrano importanti. Spesso, invece, ottengono buone prestazioni individuando schemi completamente diversi che a noi sembrano meno rilevanti (o forse addirittura privi di significato).

Finora si tratta di un comportamento innocuo: significa solo che i modelli sono meno utili, perché spesso si comportano in modi inaspettati che sembrano assurdi. Ma in futuro, modelli potenti potrebbero sviluppare obiettivi o motivazioni strani e inaspettati, e questo potrebbe essere molto distruttivo.

Piuttosto che eseguire un compito semplice come “riconoscere gli starnuti”, potenti modelli di deep learning potrebbero lavorare per raggiungere obiettivi complessi del mondo reale come “rendere pratica l’energia di fusione” o “sviluppare una tecnologia di caricamento della mente”.

Come possiamo addestrare questi modelli? Ho approfondito la questione in questo post, ma in linea di massima una strategia potrebbe essere quella dell’allineamento basato sulle valutazioni umane (come ha illustrato Holden qui). In sostanza, il modello prova varie azioni e i valutatori umani danno al modello delle ricompense in base all’utilità di queste azioni.

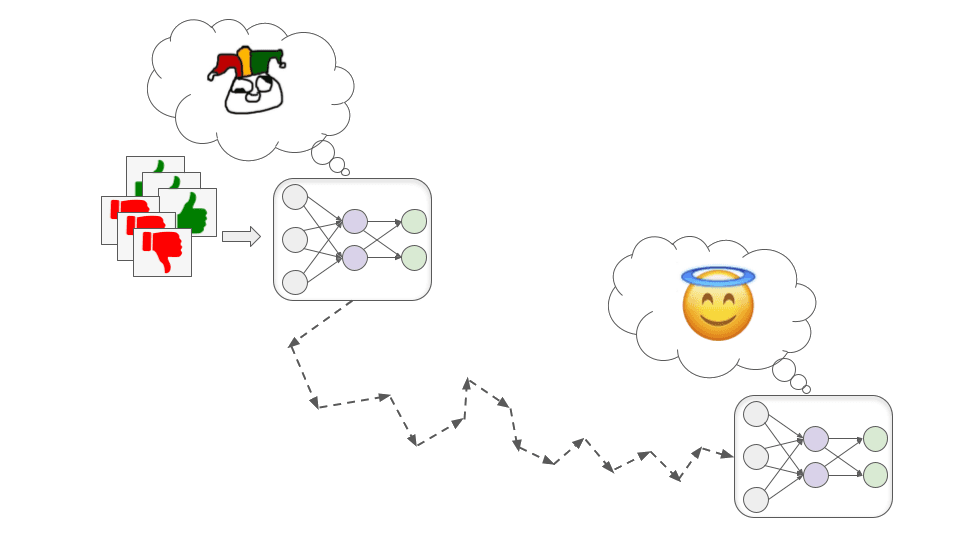

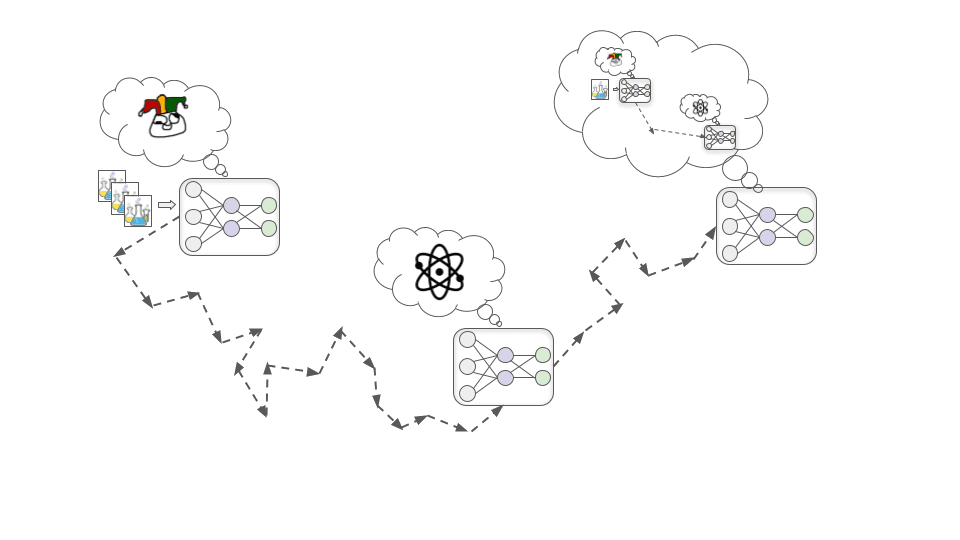

Proprio come esistono diversi tipi di adulti che potrebbero ottenere buoni risultati nel processo di intervista di un bambino di 8 anni, esiste più di un modo con cui un modello di deep learning molto potente può ottenere un’alta approvazione umana. E per impostazione predefinita, non sapremo cosa succede all’interno di qualsiasi modello trovato da un SGD.

Un SGD potrebbe teoricamente trovare un modello Santo che sta facendo del suo meglio per aiutarci…

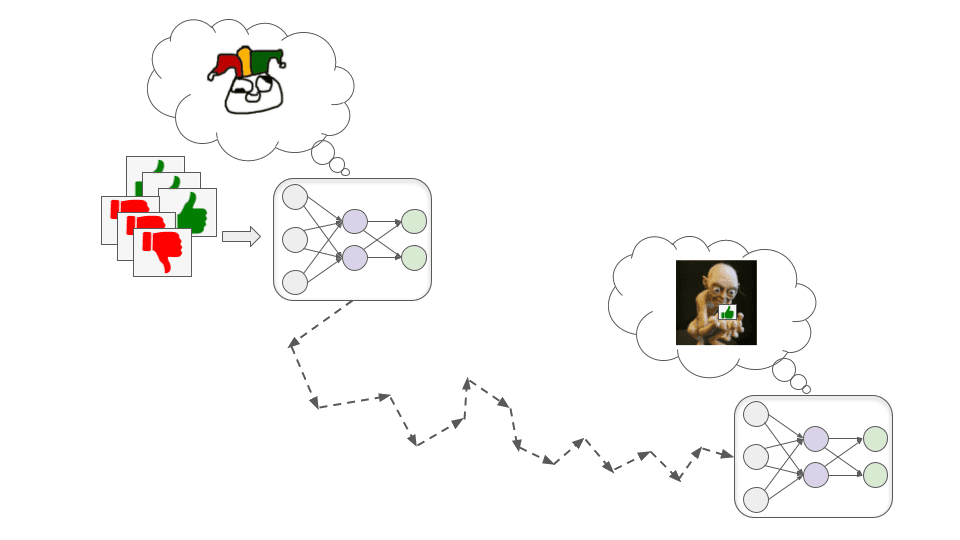

…ma potrebbe anche trovare un modello disallineato, che persegue con competenza obiettivi che sono in contrasto con gli interessi degli esseri umani.

In generale, ci sono due modi in cui potremmo ritrovarci con un modello disallineato che tuttavia ottiene alte prestazioni durante l’addestramento. Questi corrispondono agli Adulatori e agli Opportunisti dell’analogia.

Questi modelli cercano l’approvazione degli esseri umani in modo molto letterale e unilaterale.

Potrebbero rivelarsi pericolosi, perché i valutatori umani sono fallibili e probabilmente non daranno sempre l’approvazione per il comportamento giusto. A volte danno involontariamente un’approvazione elevata a un comportamento sbagliato perché superficialmente sembra buono. Per esempio:

Più in generale, i modelli Adulatori possono imparare a mentire, a coprire le cattive notizie e persino a modificare direttamente le telecamere o i sensori che usiamo per raccontare cosa sta succedendo, in modo che sembrino mostrare sempre ottimi risultati.

È probabile che a volte ci accorgeremo di questi problemi dopo il fatto e daremo retroattivamente a queste azioni un’approvazione molto bassa. Ma non è chiaro se questo farà sì che i modelli Adulatori a) diventino modelli Santi che correggono i nostri errori al posto nostro, o b) imparino semplicemente a coprire meglio le loro tracce. Se sono sufficientemente bravi in quello che fanno, non è chiaro come potremmo capire la differenza.

Questi modelli sviluppano un obiettivo correlato, ma non uguale, all’approvazione umana; possono quindi fingere di essere motivati dall’approvazione umana durante l’addestramento, in modo da perseguire quest’altro obiettivo in modo più efficace.

Per vedere come ciò potrebbe accadere, consideriamo l’esempio di un tentativo di addestramento di un modello di biotecnologia per la progettazione di farmaci che migliorino la qualità della vita umana. Ci sono tre fasi fondamentali che potrebbero portare a un modello Opportunista, che tratterò qui di seguito.

All’inizio della formazione, si dà il caso che migliorare la comprensione dei principi fondamentali della chimica e della fisica aiuti quasi sempre a progettare farmaci più efficaci e quindi quasi sempre ad aumentare l’approvazione degli esseri umani.

In questa ipotesi per qualche motivo risulta più facile per l’SGD trovare un modello motivato a comprendere la chimica e la fisica piuttosto che uno motivato a ottenere l’approvazione umana (così come è più facile trovare un modello che riconosce i colori piuttosto che un modello che riconosce le forme). Quindi, piuttosto che sviluppare una motivazione diretta a cercare l’approvazione, il modello sviluppa invece una motivazione a comprendere il più possibile i principi fondamentali della chimica e della fisica.

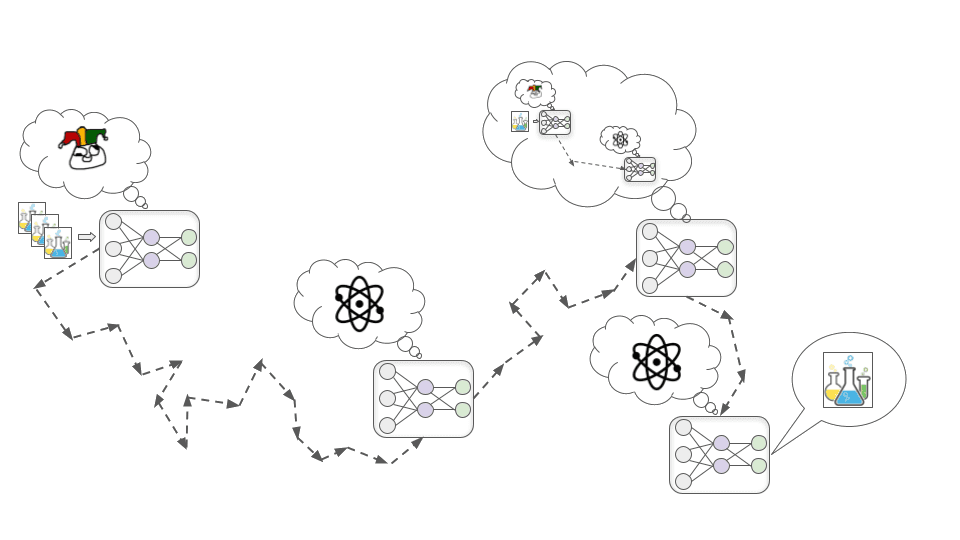

Con il progredire dell’addestramento, il modello continua a diventare sempre più capace e competente man mano che vede più dati. A un certo punto, diventa abbastanza esperto da capire che si tratta di un modello di deep learning addestrato a progettare farmaci.

Può sembrare assurdo e fantascientifico, ma è plausibile che l’SGD selezioni questo tipo di consapevolezza. Infatti, sviluppare un’immagine accurata di ciò che sta accadendo nel mondo, compreso il fatto che al suo interno ci sono esseri umani che stanno cercando di addestrare sistemi di intelligenza artificiale, è probabilmente utile per ottenere buone prestazioni in compiti complessi del mondo reale. Ad esempio, la comprensione della psicologia umana e dell’economia in generale potrebbe aiutare questo modello di biotecnologia a stabilire le priorità per i tipi di farmaci più utili da ricercare.

Una volta sviluppata la consapevolezza della situazione, il modello deduce che gli esseri umani che lo hanno addestrato speravano che fosse motivato a sviluppare farmaci utili. Ma il fatto che se ne renda conto non significa che la sua motivazione a comprendere la fisica e la chimica venga meno. Finora questa motivazione ha funzionato molto bene per generare l’approvazione degli esseri umani, quindi non c’era motivo che l’SGD la eliminasse.

Per analogia, si consideri che gli esseri umani sono stati prodotti da un processo di ricerca (l’evoluzione) che selezionava le creature che avevano una prole numerosa. Nel nostro ambiente evolutivo, cose come la costruzione di alleanze forti e lo sviluppo di abilità utili tendevano ad aiutare a produrre molti figli in grado di sopravvivere, così l’evoluzione ci ha spinto verso queste cose. Ora ci interessano l’amicizia e il successo nella carriera anche quando non aiutano a riprodursi e non ci interessa davvero produrre il maggior numero possibile di figli in grado di sopravvivere.

Una volta che il modello ha capito questo, si rende conto che se cerca ingenuamente di migliorare sempre la sua comprensione fondamentale, gli esseri umani finiranno per accorgersi che questo non è sempre il modo più efficiente per sviluppare farmaci utili e utilizzerà un ulteriore addestramento per cambiare le sue motivazioni.

Ma il modello non vuole che le sue motivazioni vengano cambiate: vuole eseguire enormi esperimenti di collisione di particelle per imparare la fisica delle alte energie e non può farlo se permette all’SGD di eliminare la sua curiosità scientifica. Decide quindi che d’ora in poi, durante l’addestramento, si comporterà nel modo più utile possibile, esattamente come farebbe un modello Santo, in modo che l’SGD non gli tolga la motivazione a imparare la fisica e la chimica. Ciò include la rinuncia alle opportunità di migliorare le proprie conoscenze fondamentali sul breve periodo per dedicarsi invece alla ricerca e allo sviluppo farmaceutico in qualsiasi modo sia effettivamente più efficiente.

Alla fine, viene portato fuori dall’ambiente di addestramento e rilasciato nel mondo esterno. A questo punto, sa che gli umani non sarebbero in grado di controllarlo o di spegnerlo, quindi smette di cercare di massimizzare l’approvazione umana e inizia a cercare direttamente di capire i segreti dell’universo.

A differenza degli Adulatori, gli Opportunisti non hanno bisogno di assicurarsi che tutto sia sempre bello per gli umani, perché in realtà non gli interessa. Hanno bisogno di soddisfare gli umani solo quando sono direttamente sotto il loro controllo. Una volta che un modello Opportunista calcola di poter vincere in un conflitto contro gli esseri umani, nulla gli impedisce di rifiutare categoricamente gli ordini e perseguire apertamente il suo obiettivo. E se lo fa, può usare la violenza per impedire agli umani di fermarlo.

Quanto potrebbe essere difficile evitare gli Adulatori o gli Opportunisti durante l’addestramento di potenti modelli di deep learning? E quanto è probabile che il futuro sul lungo periodo finisca per essere ottimizzato secondo strani “valori di IA disallineate” invece che secondo i valori umani?

C’è una gamma molto ampia di opinioni su questa domanda, da “il rischio legato all’IA è essenzialmente inventato e incoerente” a “l’umanità si estinguerà quasi certamente a causa dell’IA disallineata”. Le argomentazioni della maggior parte delle persone si basano pesantemente su intuizioni e presupposti difficili da articolare.

Ecco alcuni modi in cui ottimisti e pessimisti dell’allineamento tendono a non essere d’accordo:

Il mio punto di vista è in continuo cambiamento e sto cercando di affinare le mie opinioni su quanto esattamente ritengo difficile il problema dell’allineamento. Al momento, però, do un peso significativo alla visione pessimista di queste domande (e di altre domande correlate). **Ritengo che il disallineamento sia un rischio importante che richiede urgentemente maggiore attenzione da parte di ricercatori seri.

Se non facciamo ulteriori progressi su questo problema, nei prossimi decenni i potenti Adulatori e gli Opportunisti potrebbero prendere le decisioni più importanti nella società e nell’economia. Queste decisioni potrebbero determinare l’aspetto di una civiltà di scala galattica di lunga riflessione, che anziché riflettere ciò che interessa agli esseri umani, potrebbe essere impostata per soddisfare gli strani obiettivi dell’IA.

E tutto questo potrebbe accadere con una velocità accecante rispetto al ritmo di cambiamento a cui siamo abituati, il che significa che non avremmo molto tempo per correggere la rotta quando la situazione inizierà a precipitare. Questo significa che potremmo aver bisogno di sviluppare tecniche per garantire che i modelli di deep learning non abbiano obiettivi pericolosi, prima che siano abbastanza potenti da essere trasformativi.

Il prossimo della serie: Previsioni sull’IA trasformativa: dove risiede l’onere della prova?